Relation Humain-Robot : avec ou sans émotions ?

Nous avions posé les bases de nos réflexions sur l’utilisation des IA à travers des robots lors d’une première édition d’HUMAIN-ROBOT en juin dernier. En tant qu’acteur de la transformation digitale, nous avons en effet comme mission de maitriser cette technologie et de la déployer en préservant les intérêts humains.

Lors de notre deuxième édition, nous avons souhaité ouvrir le sujet des émotions pour creuser davantage le sujet de la relation humain-robot, aux côtés d’Anne-Marie Gaultier (présidente de Datakalab), Le Lab Suricats, et de Simon Robic (Product Manager chez iAdvize)

« Les émotions sont les mêmes pour tous les humains »

Anne Marie Gaultier nous a d’abord rappelé que les émotions sont le siège de toutes nos décisions. Un robot pouvant les détecter possède donc un savoir précieux, sur la cause de nos comportements, pouvant être utilisé à des fins marketing, pédagogiques, médicales… L’émotion est également un fort catalyseur de notre mémoire, car nous sommes plus enclins à nous rappeler des moments marquants : travailler sur l’émotion, c’est aussi travailler sur l’engagement.

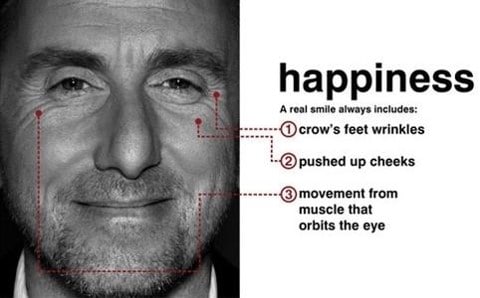

Pour un robot, une émotion est une donnée récoltée grâce à des capteurs qui analysent nos nombreux signes physiques et physiologiques, révélant nos états émotionnels. Un grand sourire connote la joie, les sourcils froncés la colère, les yeux grands ouverts la surprise… L’expression des émotions est universelle, seuls les stimuli de ces émotions diffèrent selon les cultures.

Les données reçues sont ensuite catégorisées par le robot qui intègre un modèle théorique des émotions. La plupart des modèles en comportent 7 : joie, surprise, colère, dégout, mépris, peur, tristesse. Il existe également des variantes qui naissent de leurs combinaisons. (voir les modèles de Paul Ekman et Robert Pluchnik ).

Quels principes et outils permettent cette collecte d’émotions ? Quels usages en faire ? Voici certains des exemples discutés lors du Meet-up :

FACIAL CODING : Analyses des expressions faciales grâce à une caméra.

Usage possible : Filmer une audience lors d’une conférence, un film, un spectacle… et détecter les pics d’émotions de la salle. On pourrait par exemple savoir quelle blague a le plus fonctionné pour un humoriste.

BRACELET CONNECTÉ : Détecter les micro-sudations, la fréquence cardiaque et ses variations, la température cutanée…

Usage possible : Analyser des parcours client en magasin pour déterminer quels sont les endroits clefs du magasin, là où l’émotion est la plus forte (les Magic Moments et les Pain Points) pour travailler ensuite l’amélioration de l’expérience.

RECONNAISSANCE VOCALE ET NATURAL LANGUAGE PROCESSING (NLP) : Analyser les émotions dans la voix et les mots employés.

Usage possible : Proposer un agent conversationnel (chatbot) qui répond en fonction des émotions sur un site e-commerce, une application mobile, un établissement physique, un call-center…

Le Verdict du LAB Suricats sur l’analyse de l’émotion à travers la voix

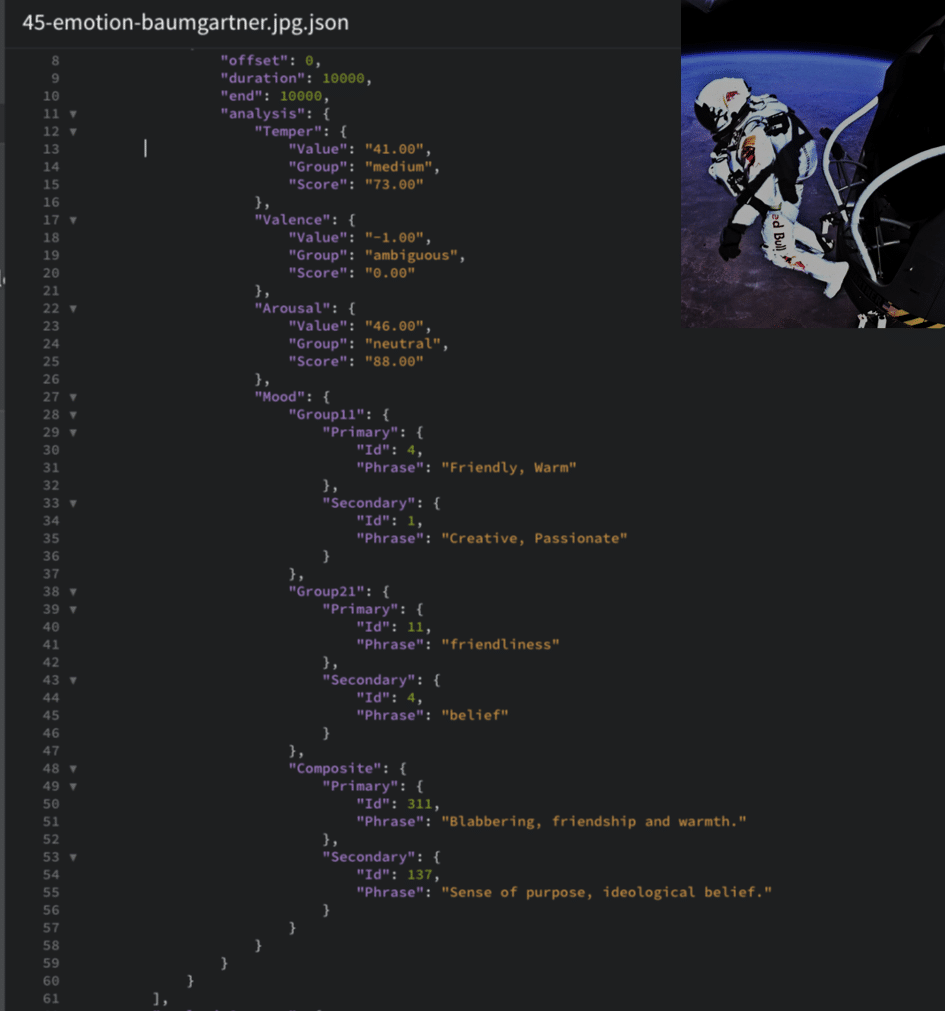

Notre LAB Suricats, dont l’une des missions est de tester les technologies d’intelligence artificielle et les usages associés, s’est penché sur la voix et sa tonalité, vecteur important de la transmission des émotions.

Pour réaliser ce test, des Suricats ont dû commenter de façon spontanée des images plus ou moins choquantes face à notre robot Hal-1, chargé de faire l’analyse des émotions en direct. Parmi les solutions testées, celle qui se démarque largement est Beyond Verbal.

Nos tests montrent que la détection des émotions par la voix est très prometteuse. Il y a un réel intérêt à intégrer cette fonction dans un Voicebot afin que ce dernier puisse mieux contextualiser la conversation et adapter son ton à la situation.

Pour aller encore plus loin, le LAB entend également coupler l’analyse de la voix avec celle du visage et des mots (NLP). Un exercice subtil car des problèmes de temporalité rentrent en jeu : la voix se traite en 15s, alors que l’image du visage en 1s par exemple. Dans un scénario d’utilisation sur un agent conversationnel, l’obligation du robot de réagir en « direct » ne permet pas ce décalage. L’analyse à partir d’un couplage Voix/Mots/Visage est donc plus propice pour des usages en « temps différés », comme l’analyse de tendances ou de parcours (ex : call center, service client, service d’accueil…)

L’avenir du marketing est-il aux robots conversationnels émotionnels ?

Le canal conversationnel, tiré par les mastodontes Messenger, Instagram, Whatsapp… semble devenir le point central du déploiement marketing de demain. C’est ce que défend Simon Robic.

Dans l’ère de l’expérience utilisateur et de la simplification, c’est ce canal qui est le plus naturel pour les échanges humains. D’ailleurs, certains bons élèves de l’innovation, comme Airbnb et Blablacar, font désormais de la conversation leur positionnement marketing principal.

Mais faut-il pour autant robotiser ce canal conversationnel ? Les résultats actuels montrent une réelle insatisfaction vis-à-vis de ces agents conversationnels. Certains services comme Ibbu proposent un retour à des services conversationnels de très haute qualité assuré par des experts… humains ! Un beau contrepied aux tendances technologique actuelles.

« Dans une conversation entre humains passionnés, on atteint des niveaux de satisfaction au-dessus de 80% ; seulement 30% pour les chatbots », nous dit Simon, en ajoutant que tous les autres indicateurs (achat, fidélité…) sont aussi en hausse avec ce service.

D’ailleurs, un chabot, même en intégrant les émotions, est loin de passer le test de Turing. Alors, à quoi bon intégrer la dimension émotionnelle dans un chatbot si le chatbot est lui-même remis en question ?

L’IA a ses limites et c’est à ses propres limites qu’il faut l’employer : traiter les tâches les plus simples et chronophages tout en donnant, avec la reconnaissance d’émotions, une certaine « empathie » au robot qui lui permet de proposer des réponses en fonction de l’humeur présumée de son interlocuteur.

Conclusion

Intégrer la prise en compte des émotions offre donc de nombreuses opportunités pour accompagner l’humain. Si on y voit pour certains usages un intérêt direct, comme pour l’analyse de parcours utilisateurs ou de tendances comportementales, la marche est encore haute pour qu’un agent conversationnel puisse tenir une conversation humaine de bout en bout. A nos yeux, l’IA a donc pour mission d’augmenter l’Humain et non pas de le remplacer !

Toute la tribu Suricats remercie les participants de leur contribution à cette réflexion collective et vous propose de poursuivre ces échanges lors d’un prochain meet-up.

Vous voulez aller plus loin ? Notre collectif vous livre ses secrets :

- Comment l’IA et la commande vocale commencent à transformer notre quotidien ? Par ici

- Les enjeux et opportunités de la relation bancaire de demain grâce à l’IA. Par ici

- La saga de notre Suri-Robot : Episode 1 & Episode 2

- Notre MBA sur l’éthique numérique avec Laurence Devilliers